最近、仕事で測位装置をよく使うのですが高精度に位置情報を取得する方法が色々あるので、GPSをベースにした測位技術について勉強がてらまとめてみました。

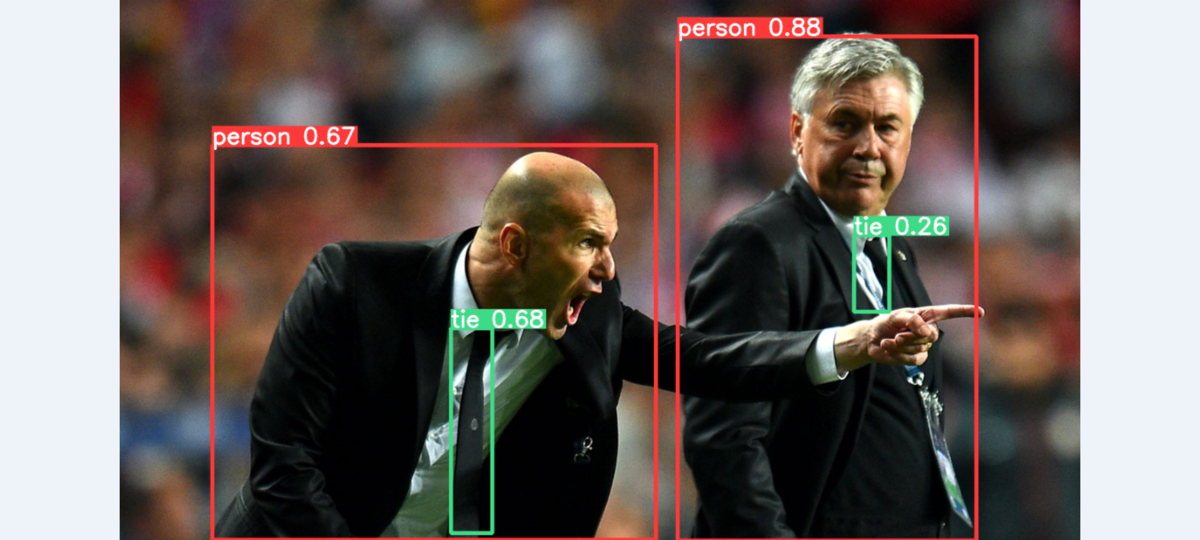

概略図はこのような感じです。

GPS

これらの衛星測位技術のベースになる技術。

正式名称はGlabal Positioning Systemです。

後述のGNSSと区別するために言及しておきますが、GPSはアメリカが運用するシステムとなります。

正確な時計(原子時計)と正確な軌道情報を持った衛星から受信する時間と軌道情報を複数(4つ以上)の衛星から得ることで自己位置を特定する技術。

原理的には3つの独立な方向の衛星の情報を使えば自己位置が特定できるが、受信機(自己)が正確な時計を持っていないため未知変数が一つ増え、最低4つ以上の衛星が見えないと自己位置推定できない。

後述する方法より精度が低い。

GNSS

次に聞きなじみが少ないGNSSです。

正式名称はGlobal Navigation Satellite Systemです。

前述したアメリカのGPSに加えて、測位衛星を持っている国は複数あります。

そこで、その世界各国の測位衛星を使ったシステムがGNSSとなります。

有名なところでいうと日本の測位衛星、準天頂衛星みちびきもGNSSの測位衛星の一つになります。

単純に見える衛星数が増えることで位置特定精度が向上します。

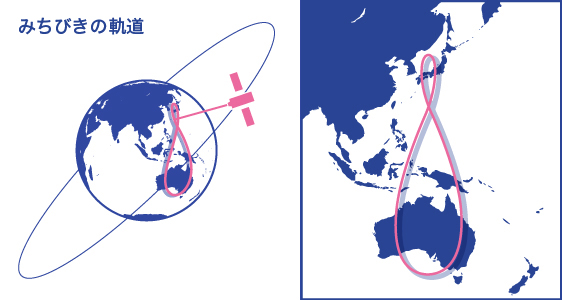

とくに日本のみちびきが通る軌道は日本を中心となっているので日本でのGNSSによる位置精度向上に貢献していることが分かります。

みちびきの軌道|みちびきとは|みちびき(準天頂衛星システム:QZSS)公式サイト - 内閣府

また、みちびき等の新しい衛星は複数の周波数をもつことで電離層による電波の伝送の遅延による誤差も改善しています。

衛星測位サービス|みちびきとは|みちびき(準天頂衛星システム:QZSS)公式サイト - 内閣府

GPS-INS/GNSS-INS

GPS/GNSSによる位置特定に加えて慣性センサ(加速度・ジャイロセンサ)の値を用いて自己位置精度を補正して精度を向上させる手法です。

慣性センサの情報を使えば剛体を仮定すると単純に加速度・角速度を積分することで自己位置がどのように移動したか分かります。

実際にはセンサ値にはノイズが乗っており、積分することでそのノイズが蓄積されて大きな誤差となってしまいます。

そこでGPS/GNSSの位置情報が使えない時(精度が低い時に)慣性センサのデータを使って自己位置を補間する手法です。

実際に都市部になるとビルの影やトンネルで受信できる測位衛星が少なくなってしまうのでその間を慣性センサで補助します。

RTK-GNSS

最後にRTK-GNSSです。

RTKはReal Time Kinematicの略称となっています。

この手法では既知の位置座標にある基地局が受信したGNSSの受信データ(位相データ)を使用して誤差を修正する方法です。

なのでGNSSの受信機を自分で持っているだけではなく、基地局がが必要になります。

詳細な位相差による修正方法は以下に説明されていそうです。(しっかり見ていない)

http://www.nda.ac.jp/~nami/research/pdf/CGSIC2001.pdf

基地局に関しては自身で設置することもできます。

しかし、日本においては全国1300カ所に国土地理院が設置した基地局があり、そのデータを使用することができます。

そこでインターネットを使用してこれらの基地局のデータをしようすることで自身で基地局を設置することなくRTK-GNSSを使った高精度な位置測定をすることができます。

これをネットワーク型RTK-GNSSと言います。

日本ではソフトバンクとジェノバがこれらのネットワーク型のRTK-GNSSのサービスを提供しています。

高精度測位サービス ichimill(イチミル) | 法人向け | ソフトバンク

以上、測位衛星を使った測位技術まとめでした。